AI時代を支えるデータセンターとは?拡大の背景と冷却問題の解決策

生成AIの台頭により、あらゆる産業でAI活用が進むなか、膨大な演算処理とデータ管理を支えるAIデータセンターの重要性が急速に高まっています。

本記事では、AIデータセンターとはどのようなものなのか、従来型のデータセンターと比較しつつ解説します。また、AIデータセンターを構成するGPUサーバーと冷却システム、さらには消費電力や持続可能性などについてもわかりやすく紹介していきます。

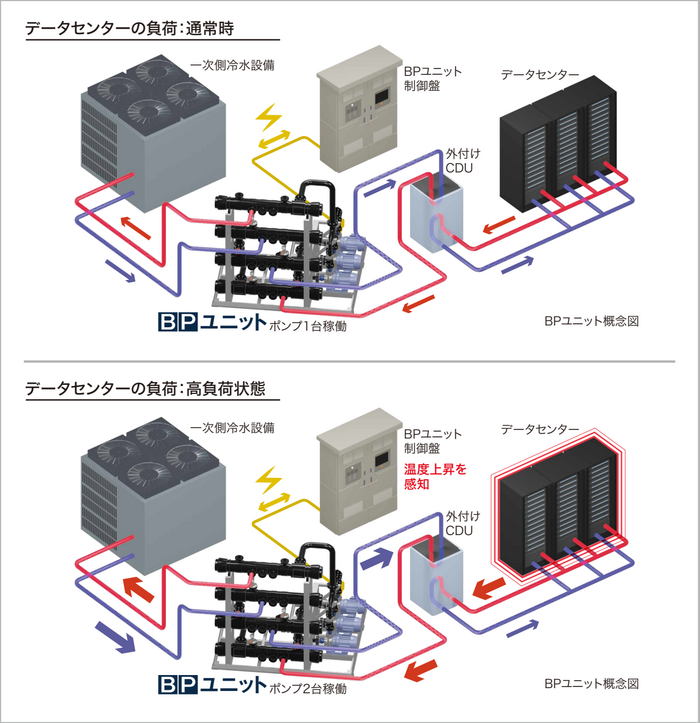

株式会社バーテックでは、データセンター向けの24時間365日連続運転が可能なポンプシステム「BPユニット」を発売いたします。データセンターの冷却システムを標準化・ユニット化し、サーバーの拡張に柔軟に対応できるスケーラブルなシステムです。また、ABCI方式や最適化されたポンプ制御や排熱の見える化、高い冷却能力などにより、省エネで効率的な運用を実現します。

1.AIデータセンターとは?従来型との違いを完全解説

AI技術の急速な発展により、データセンターにも新たな役割と機能が求められるようになっています。この章では、AIデータセンターの定義と従来型データセンターとの違いについて、わかりやすく解説します。

(1)AIデータセンターとは?

AIデータセンターとは、AIモデルの学習や推論といった高度な演算処理に特化したデータセンターを指します。

近年、生成AIや自然言語処理など、AIに関連した大量かつ高速なデータ処理へのニーズが増加しています。これに対応するため、AIデータセンターでは大容量・高密度な処理環境と、効果的な冷却・電力管理体制を備えているのが特徴です。

例えば、AIのディープラーニングでは複雑な判断を行うために、数千件から数万件のデータを処理する必要があるといわれています。この膨大な量のデータを高速処理するために、AIデータセンターでは並列処理を得意とするGPU(Graphics Processing Unit)やTPU(Tensor Processing Unit)といった専用ハードウェアを活用し、高度な演算能力を確保しています。

また、学習や推論の効率化を支えるデータ転送速度を最大化するための高速・低遅延ネットワークや膨大なデータを管理・保存するための大容量ストレージ、さらに稼働に伴って発生する大量の熱を効率よく冷却するための高度な冷却システムも備えています。

このように、AIデータセンターは「AI特有の膨大な計算リソースへの最適化」を目指して設計されているため、専用設備の導入を前提とした、より高度なインフラ技術が求められています。

(2)従来型データセンターとの比較

従来型のデータセンターは、企業の業務システム、ウェブサービス、クラウドストレージなど、、幅広い用途に対応できるように汎用性の高い設計がなされています。そのため、プロセッサには幅広いタスクを処理できるCPU(Central Processing Unit)が使用されています。

また、平均的なCPUサーバーの消費電力量は1サーバーあたり220W程度で、ラックを密閉し冷気と暖気を分離して空調効率を改善するコンテインメントに加え、床下から送風する空冷空調設備や水による熱交換で循環水を冷却する水冷空調設備といった冷却設備が一般的です。

一方、AIデータセンターでは、AIのトレーニングや推論処理など、非常に高い演算能力を必要とする作業を円滑に進めるために、CPUよりも並列処理能力に特化したGPUやTPUを多数搭載した高性能サーバーを大量に稼働させるという違いがあります。

また、最新のGPUサーバーの消費電力量は1サーバーあたり10kW(1万W)以上になり、それに伴って発生する大量の熱を効率よく冷却するため、液浸冷却やリアドアクーリングといった空調以上の性能を持つ最新冷却技術の導入が欠かせません。さらに、電力需要も格段に大きく、施設全体のエネルギー効率を最適化するための工夫も必要となります。

このように、従来型データセンターが多目的に対応する「汎用性重視」の設計であるのに対し、AIデータセンターは特定の処理に特化した「高性能・高密度志向」のインフラであるという点が、両者の本質的な違いといえます。

| 従来型データセンター | AIデータセンター | |

| 主な用途 | 業務システム、ウェブサービス、クラウドストレージなど | AIの学習・推論処理など |

| 設計思想 | 幅広い業種・業務に対応できる柔軟設計 | AI処理に最適化された専用設計 |

| プロセッサ | CPU | GPU・TPUなど |

| 消費電力量 | 1サーバーあたり220W程度 | 1サーバーあたり10kW以上 |

| 冷却方法 | 空冷空調・水冷空調 | 液浸冷却・リアドアクーリングなど次世代方式 |

2.AIデータセンターが急拡大する背景

AIデータセンターは、わずか数年で急速にその需要を高めています。背景には、AI技術の普及と膨大なデータ処理ニーズの増大という、現代社会ならではの変化があります。ここでは、その拡大理由について詳しく解説します。

(1)AI技術の急速な普及

AIデータセンターが急増する背景として、まずAI技術の急速な普及が挙げられます。

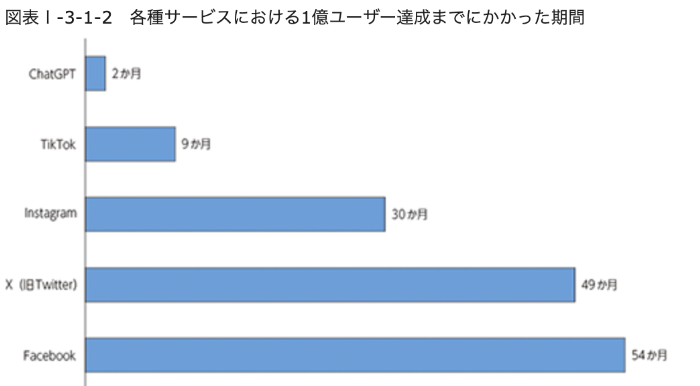

例えば、生成AIの代表ともいえる「ChatGPT」はサービス公開からわずか2か月ほどで1億ユーザーを獲得しています。これは、X(旧Twitter)やInstagramなど既存のオンラインサービスと比較しても異例の速さといえます。

画像引用:総務省 令和6年版情報通信白書

また、AIのオープンソース化により、一般企業から個人の開発者にまでAIの開発・運用が可能となったことも、AI普及の一端を担っているといえます。現在では、工場における不良品検品、小売業における需要予測や無人レジでの映像認識、金融業におけるクレジットカードの不正検知など、幅広い産業に急速に浸透しています。

このように、AIを活用したビジネスモデルやサービスの開発が加速した結果、企業にとってAIインフラが欠かせない存在となりました。IT専門調査会社IDC Japan株式会社の発表によると、2023年は生成AIに対する関心が急速に高まり投資が活発化した結果、国内AIインフラ市場の支出額は前年比46.1%増加し、1,000億円以上の規模にまで急成長しました。さらに、2022年から2027年における支出額の年間平均成長率は16.6%、2027年の支出額は1,600億円以上の規模になると予測されています。

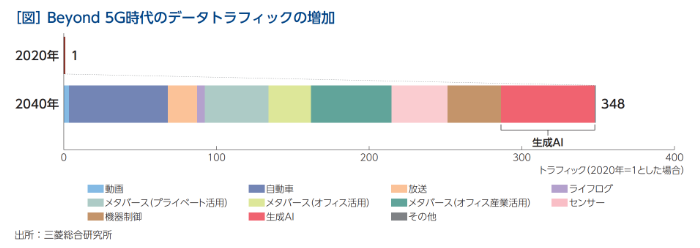

また、三菱総合研究所の予測によると、2030年代にはテクノロジーの発展や少子化の影響により、あらゆる産業や個人へのAIサービスの提供が予測されています。その結果、情報爆発により2040年のデータ流通量は2020年の348倍にもなると試算されています。

画像引用:https://www.mri.co.jp/knowledge/mreview/dia6ou000005bv97-att/mr202307.pdf

今後はより広範なフィールドでのAI活用や、自動運転やビッグデータ解析といった異なる種類のデータを同時処理して高度な判断を行うマルチモーダルAIの進展・普及が想定されるため、AIデータセンターに対する需要は高まり続けるでしょう。

(2)増大するデータ処理とリアルタイム分析の必要性

AI技術の進展・普及に伴い、取り扱うデータ量が飛躍的に増大するとともに、リアルタイム分析の必要性も出てきています。

例えば、車の自動運転では、AIがリアルタイムで画像処理や危険予測、ルートのプランニングなどを行い、各状況において最適な認知・判断・制御を行う必要があります。2023年に発表された情報処理推進機構(IPA)の資料によると、自動運転に必要なデータ処理量は、1日1台あたり767TBになると報告されています。さらに、1日あたり5万台の物流トラックが通行していると仮定すると、1日あたり約3,835万TBもの莫大なデータ処理を行う必要があり、サーバーラック約12,000台の処理量に相当すると試算されています。

このように、AIにも即時の意思決定が求められる場面が増え、リアルタイムで大量データを分析・フィードバックできる環境が必須となっています。このニーズに応えるためには、高速なデータ伝送と処理を可能にするAIデータセンターの存在が不可欠です。

AIデータセンターでは、ネットワーク設計そのものもAIに最適化され、複雑なデータフローに柔軟かつ迅速に対応できる構造が採用されています。結果、データボリュームの増大やリアルタイム分析ニーズに対しても、高いパフォーマンスを維持できる仕組みが整えられているのです。

3.AIデータセンターを支える最先端技術

AIデータセンターは、従来の施設とは異なる高性能・高密度な環境が求められます。本章では、AIデータセンターを支える重要な技術について詳しく紹介していきます。

(1)GPUサーバーの運用

AIの高度な演算処理には、並列処理性能に優れたGPUサーバーが欠かせません。GPUはもともと3Dグラフィックスなどの画像処理の高速化のために開発されたプロセッサであり、CPUのような複雑な計算はできません。その代わり、数千個に及ぶコア数により、大量のデータを並列的に処理することを得意としています。そのため、ディープラーニングや大規模言語モデルの学習において圧倒的な計算能力を発揮します。

一方、運用面では膨大な熱量を発生させるGPUを安定的に稼働させるため、冷却性能や電源供給の強化が重要となります。特にGPUサーバーの消費電力はサーバー1台あたり10kW以上で、かつ複数台がサーバーラックで同時に稼働するため、20kWまでの発熱量にしか対応できない従来の空冷式の冷却能力では不十分といわれています。そこで、GPUサーバーにて用いられる高度な冷却技術について、次に詳しく解説します。

(2)高度な冷却技術

GPUサーバーから発生する大量の熱に対処するための、高度な冷却技術について紹介します。

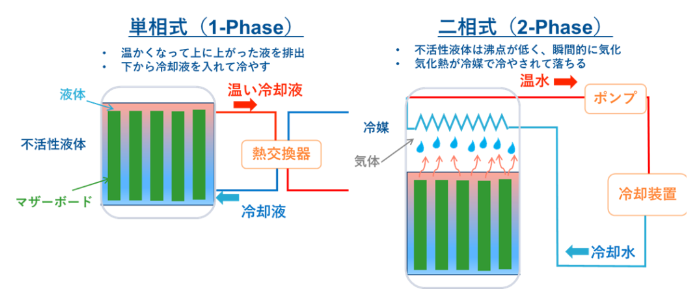

①液浸冷却

画像引用:https://datacenter-solution-forvice.com/iceraq/

液浸冷却とは、フッ素系不活性液体やシリコンオイルなど絶縁性の冷却液にサーバー本体を浸す方式です。冷媒によって直接熱を吸収するため、空冷式や水冷式と比較して冷却効率が高く、1ラックあたり40kWの消費電力にも対応できます。また、液体による密閉状態であるため、急激な温度変化によるサーバーの故障リスクを低減できるメリットもあります。

液浸冷却には、冷却液が液体のまま自然に循環して冷却する単相式と、気化と液化を繰り返して冷却する二相式の2種類があります。一般的に、メンテナンス面では単相式、電力効率面では二相式の方が優れているとされています。

画像引用:https://unipole.co.jp/news-blog/p6261.html

一方で、冷媒に用いる液体の費用が高価である点、フッ素系不活性液体の生産トップシェアの3M社が製造から撤退した点などにより、導入ハードルは高くなっています。

| 液浸冷却については以下の記事で詳しく解説しています。 |

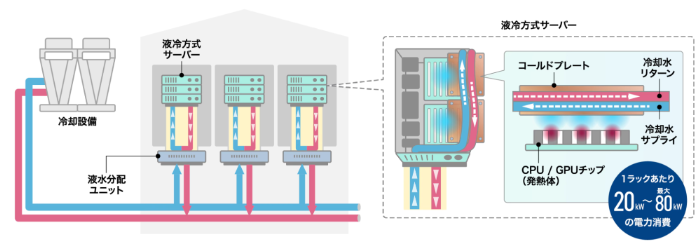

②DLC(ダイレクト・リキッド・クーリング/直接液冷)

画像引用:https://www.ntt.com/business/services/greennexcenter.html

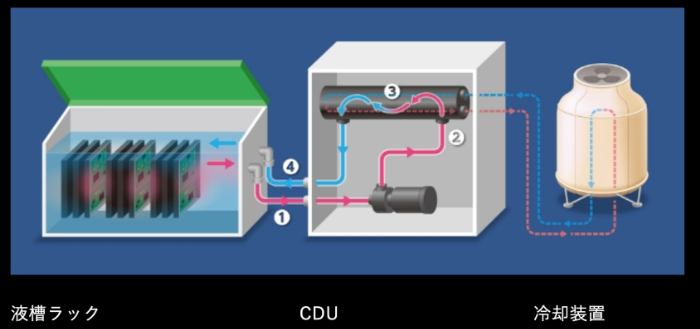

DLCはダイレクト・リキッド・クーリング(直接冷却)の略称で、内部に冷却液の通る管を設けた金属製の冷却プレートとCDU(冷却水分配ユニット)、冷却塔などで構成されます。

CPUやGPUに接触するように設置された冷却プレートの内部を冷却液が循環することで、発熱体から冷却プレート、冷却液へと熱エネルギーが伝わり、効率的に温度を下げる仕組みです。高温になった冷却液はラック下部やサーバールームの床下に設置されたCDUで放熱することで温度が下がり、ポンプによって再び冷却プレートへと取り込まれます。CDUでは二次冷却水を用いて高温となった冷却液の放熱を促し、さらに二次冷却水は冷却塔で熱エネルギーを放出します。

DLCであれば、1ラックあたり80kWから最大200kWまでの消費電力を冷却できると見込まれていますが、導入にあたってはDLC方式に対応した専用サーバーや床下への配管などが必要となる点には注意しましょう。

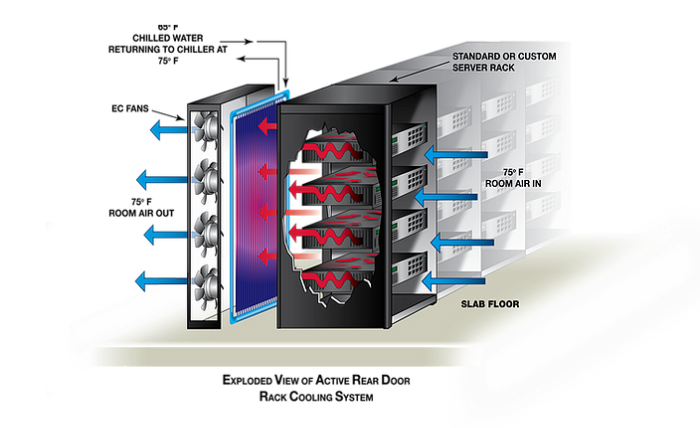

③リアドアクーリング

画像引用:https://www.dcasia-ltd.com/product/cooling/reardoor/motivair/

リアドアクーリングは、ラックの背面扉(リアドア)に取り付けた熱交換器により、サーバー後方から排出される熱風を直接冷却する方式です。1ラックあたり最大50kWの消費電力を冷却可能で、排出された熱は即座に冷却されてサーバールームへ送り出されるため、データセンター全体の空調負荷を軽減できます。

リアドアクーリングで用いられる冷水は、結露を防ぐため比較的高めの温度に設定されています。そのため、外気の涼しい中間季や冬季であれば、冷却塔を利用して冷水を供給する「フリークーリング」を用いることが可能で、省エネルギーにもつながるメリットがあります。また、DLCと同様に冷水を通すための床下への配管が必要ですが、ラックに冷却装置が組み込まれているため、設置や移動、故障時の交換は比較的容易です。

リアドアクーリングには、熱交換器のみで構成されるパッシブ型と、ファンと熱交換器を内蔵するアクティブ型の2種類があります。内蔵ファンを搭載したアクティブ型のほうが効率的な熱交換が可能ですが、消費電力が少ないのはパッシブ型の方です。

4.AIデータセンターが直面する課題と解決策

AIデータセンターは飛躍的な進化を遂げる一方で、設備面やエネルギー面など多くの課題にも直面しています。本章では、主要な課題と、それに対する解決策について詳しく紹介します。

(1)冷却システムに付随するポンプの課題

DLCやリアドアクーリングなどの冷却システムでは、CDUに接続される一次側冷却機の内臓ポンプは一定の流速でしか押し出せないものが多く、流量に上限があります。そのため、状況により流量を柔軟に変化させる必要がある場合、外付けのポンプが必要になります。また、一次側と二次設備側の責任分岐点にあたるポンプが規格化されていないという課題もあります。

これらの課題に対して、有効な解決策として期待されているのが株式会社バーテックのポンプシステム「BPユニット」です。

BPユニットはデータセンターの冷却システムを標準化・ユニット化し、サーバーの拡張に柔軟に対応できるスケーラブルなシステムとなっています。そのため、設計・納期の大幅な短縮が可能になり、24時間365日の連続運転が求められるデータセンターでのポンプシステム構築の難易度を格段に下げられます。

また、ABCI方式による省スペース化とコスト削減のほか、最適化されたポンプ制御や排熱の見える化、高い冷却能力、強力なポンプシステム、遠隔制御対応による、省エネルギーへの貢献と効率的な運用を実現できます。

| データセンターの水冷システム構築における課題を解決し、効率的かつ持続可能な運用を実現する 「BPユニット」の詳細はこちら |

(2)設備・建設投資の課題

AIデータセンターでは、高密度なサーバー構成や特殊な冷却方法に対応するため、専用の設備投資が必要となります。

例えば、床の耐久性や防水性が求められます。例えば、空調を備えた従来型のデータセンターでは、1平方メートルあたり500〜700kgの床荷重であるのに対し、AIデータセンターでは、1平方メートルあたり1,000〜2,000kgもの床荷重となります。これは、高密度に集積されたGPUサーバーと、ラック内にまで冷却水を供給する冷却装置を備える必要があるからです。また、GPUサーバーの冷却方法には冷却水が用いられるため、万が一液体が漏れてしまった場合に備えて、フロア全体にわたって床の防水対策が必要となります。

さらに、DLCやリアドアクーリングでは床下の配管や冷却塔なども必要となるほか、膨大な電力供給に対応するためのバスダクトと呼ばれる大容量の配電設備や、サーバーラックの運搬・設置を効率化する電動リフターなどの導入も不可欠です。

そのため、従来型のデータセンターをすぐにAIデータセンターへと移行するのは難しく、新たな建設にも相応のコストがかかります。例えば、NTTが2025年度の稼働に向けて京都府内にて建設している「京阪奈データセンター(仮称)」は約400億円が投じられていると報道されています。また、建設業界における人手不足や資材の価格高騰により、データセンターの建設コストは2024年第一四半期から1年で約1.5倍にも増加したとの報告もあります。

このように、AIデータセンターの構築・新設はかなりハードルが高いといえます。一方で、データセンターではない既存の施設を転用する動きも見られます。例えば、工場や製鉄所は大口用の高圧電力が通っていることが多いため、その跡地をAIデータセンターへと転用する動きがあります。例えば、三菱商事とJFEホールディングスは高炉を休止した東日本製鉄所京浜地区の跡地に、ソフトバンクとKDDIは2024年に生産停止したシャープ堺工場の跡地にデータセンターを建設する予定です。ほかにも、株式会社ハイレゾは国立研究開発法人と香川県の助成を受け、香川県内の廃校を利用したAI開発用データセンターを開設した例もあります。

(3)省エネルギー・電力管理の課題

AIデータセンターは、高密度のGPUサーバーや冷却装置の稼働により、従来型のデータセンターよりも大量の電力を消費します。2025年4月に発表されたIEA(国際エネルギー機構)の報告によると、一般的なAIデータセンターであっても年間10万世帯分の電力を消費しているとの指摘がありました。

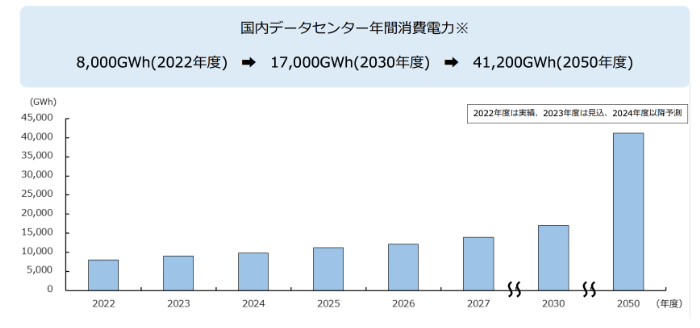

また、2024年に発表された株式会社富士キメラ総研の調査によると、2022年度に約8,000GWhだった国内データセンターにおける年間消費電力は、2030年度には約17,000GWh、2050年度には41,200GWhにまで達する見通しです。そのため、施設全体の受電容量を大幅に強化する必要があります。

このように増え続ける電力需要に対して、電力使用量の削減と再生可能エネルギーの利用が求められています。

例えば、NTTコミュニケーションズ株式会社が2030年頃の実用化を目指している「IOWN」構想では、端末からネットワークに至るすべてにフォトニクス(光)ベースの技術を導入することで超高速・超低消費電力を実現する技術「オールフォトニクス・ネットワーク(APN)」の研究・開発を行っています。

IWONの導入により、2040年度におけるNTTグループの電力消費量を約半分にまで削減、さらに残り半分については再生可能エネルギーを導入し、カーボンニュートラルを実現できるとしています。また、APNで連携された分散型データセンターを再生可能エネルギーの供給地近辺に配置することで、効率的なエネルギー供給も目指します。2025年3月には、APNで接続した3拠点のデータセンターにGPUサーバーを分散配置した環境で、NTTの開発した大規模言語モデル「tsuzumi」の学習実証実験にも成功しました。

ほかにも、データセンターや工場、ビルなどにおけるエネルギー使用状況を分析・改善するエネルギーマネジメントシステム(EMS)にも注目が集まっています。EMSにより、使用している電力や流量をリアルタイムに収集し、分析・制御することで、いつ・どこで・どのように電力が使用されているか把握でき、ムダな電力使用を削減できます。

5.AIデータセンターの今後と持続可能性

AIデータセンターの急増に伴い、各国ではエネルギー使用量や環境負荷に関する規制強化の動きが顕著になっています。

例えば、欧州委員会(EC)では、データセンターの持続可能性を評価するためのエネルギー効率指令(Energy Efficiency Directive EED)を2018年12月に改正し、2030年までに32.5%のEUエネルギー効率改善目標を達成する目標を設定しました。また、500kW以上のデータセンターに対して、床面積や設置電力、データ量、エネルギー消費量、電力利用率、温度設定値、排熱利用率、水使用量といった項目について、データセンターごとに開示を求める制度整備を要請しました。この指令により、データセンター運営者はエネルギーや水の使用状況を報告し、効率向上の取り組みを示すことが求められています。

これに伴い、ドイツではEEDで設定されている開示義務に加え、データセンターの構築・運用に伴うエネルギー効率の要件を独自に設定した国内法(エネルギー効率法)が施行されました。

一方、日本では脱炭素電力の確保やGX(クリーンエネルギーへの転換による社会変革)への必要性から、総務省・経済産業省が「デジタルインフラ(DC等)整備に関する有識者会議」を通じて、データセンターの地方分散や再生可能エネルギーの活用を推進しています。また、NTTのIOWN構想におけるAPNに代表される「オール光ネットワーク」による省電力化とデータセンターの分散立地による電力消費の分散・地産地消化により、脱炭素を目指しています。

まとめ

AIデータセンターとは、AIモデルの学習や推論といった高度な演算処理に特化したデータセンターです。並列処理を得意とするGPUサーバーや膨大な熱を処理するための高度な冷却システムなどにより構成されています。生成AIの普及やビジネス利用への拡大に伴い、AIデータセンターの需要は高まり続けています。その一方で、電力効率の向上や再生可能エネルギーの活用も、一層求められています。

株式会社バーテックでは、データセンター向けの24時間365日連続運転が可能なポンプシステム「BPユニット」を発売いたします。データセンターの冷却システムを標準化・ユニット化し、サーバーの拡張に柔軟に対応できるスケーラブルなシステムです。また、ABCI方式や最適化されたポンプ制御や排熱の見える化、高い冷却能力などにより、省エネで効率的な運用を実現します。

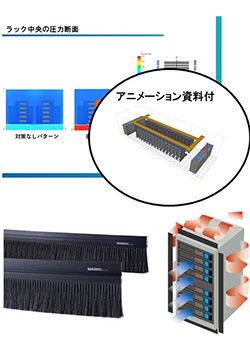

これで安心。ブラシ効果を裏付ける決定版

ヒートシャット®・ブラシ CFD解析資料

データセンターの安定稼働に大きく貢献「冷却」ではなく「排熱」するために、ブラシが空気の流れをコントロールすることを示した解析資料です。